今天看新闻,清华大学推出了开源对话机器人ChatGLM,可本地部署,如同游戏硬件需求分档一样,显存最低不过6G,而推荐则至少13G。

如此一来,我12G显存的3060机器只能跑低配了。

系统安装非常简单,下载了预训练的模型,提问了跟ChatGPT与新必应同样出丑的《血泪篇》,结果答案一样令人无语。

系统安装非常简单,下载了预训练的模型,提问了跟ChatGPT与新必应同样出丑的《血泪篇》,结果答案一样令人无语。

而关于围棋历史名局的标准,低配版回答的更像是五W的凑数文字。

看看低配不堪用,便租了一台24G显存的3090的云服务器,安装同样顺利,时间都花费在预训练模型上传上了。

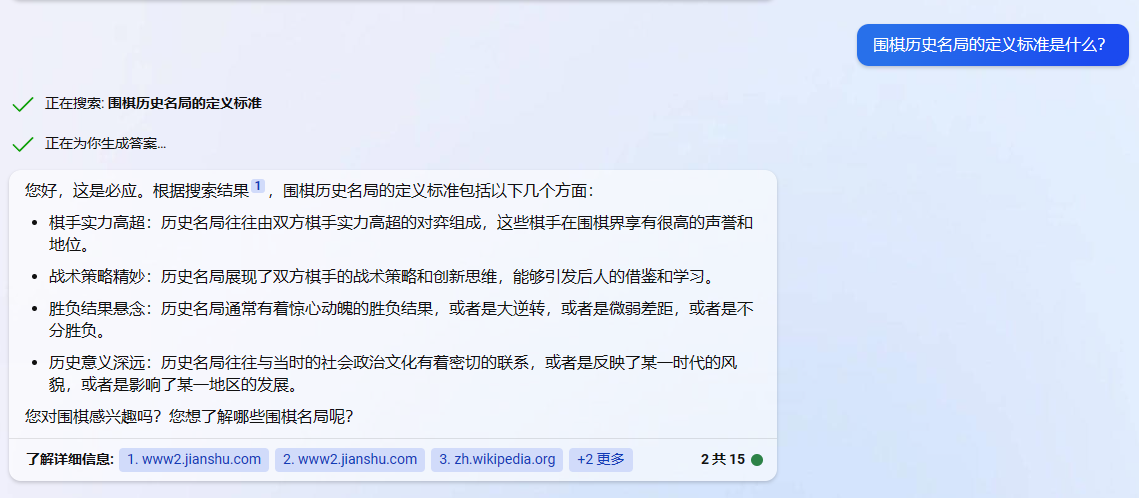

运行起来后提问同样两个问题,关于历史名局回答还算靠谱,毕竟模型体积是低配版的三倍。而血泪篇则依然围绕聂卫平造谣,只不过对手换成了藤泽秀行。

运行起来后提问同样两个问题,关于历史名局回答还算靠谱,毕竟模型体积是低配版的三倍。而血泪篇则依然围绕聂卫平造谣,只不过对手换成了藤泽秀行。

对chat类AI而言,相比技术,更为重要的是数据。现在,咬牙也要开放。

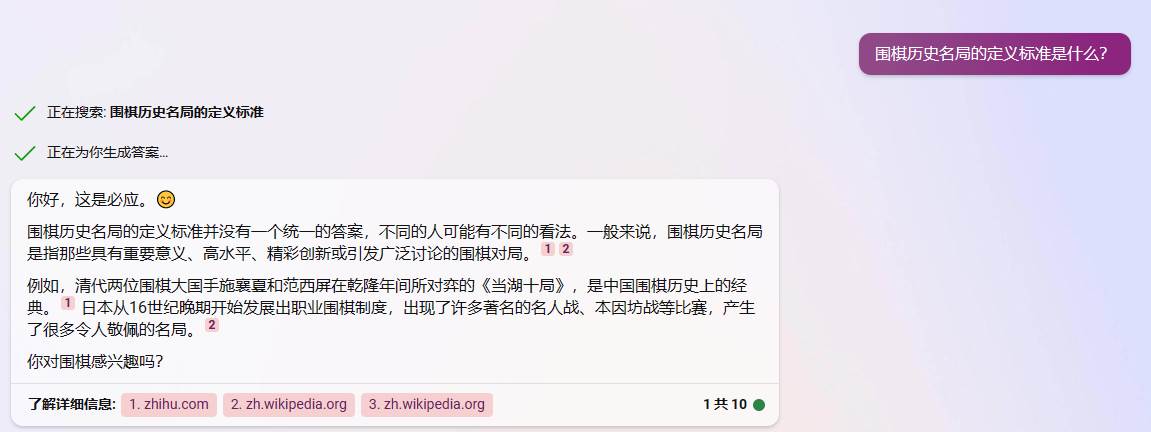

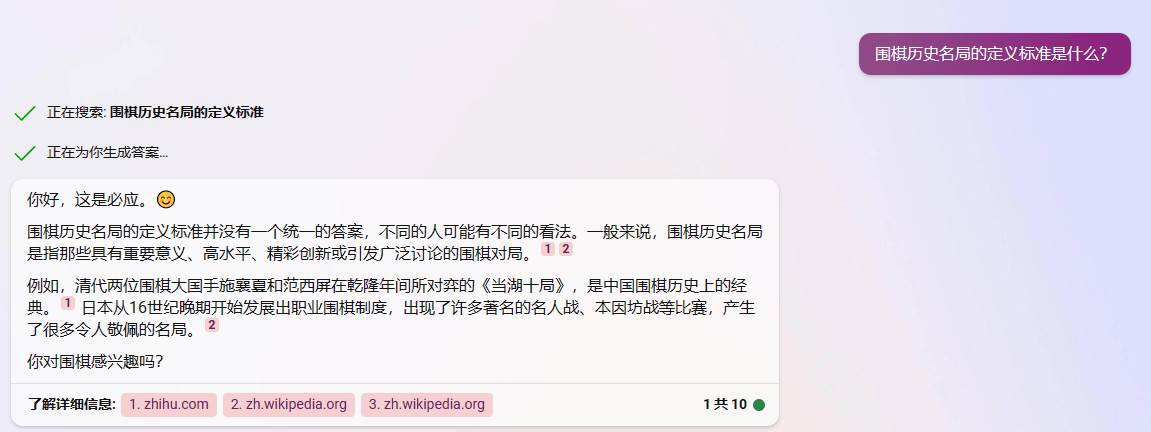

我当时也觉得挺搞笑的。这是新必应在回答围棋名局标准时的一个画蛇添足的实例。本来前面应该是参照ChatGPT的数据,回答的堂堂正正,谁知道在举的例子中却露出马脚,简直就是狐狸尾巴。

我当时也觉得挺搞笑的。这是新必应在回答围棋名局标准时的一个画蛇添足的实例。本来前面应该是参照ChatGPT的数据,回答的堂堂正正,谁知道在举的例子中却露出马脚,简直就是狐狸尾巴。