下午看到新闻,梁小龙去世。

很快梁小龙去世登上了微博热搜头条。在众多纪念微博中提到的角色,更多的是电影《功夫》中的火云邪神。

记得当年《功夫》上映时,同事小B还有些愤愤不平,说电影里面把梁小龙扮演的火云邪神设计的很猥琐。

这应该就是代沟吧。

这也说明,我们真的老了。

下午看到新闻,梁小龙去世。

很快梁小龙去世登上了微博热搜头条。在众多纪念微博中提到的角色,更多的是电影《功夫》中的火云邪神。

记得当年《功夫》上映时,同事小B还有些愤愤不平,说电影里面把梁小龙扮演的火云邪神设计的很猥琐。

这应该就是代沟吧。

这也说明,我们真的老了。

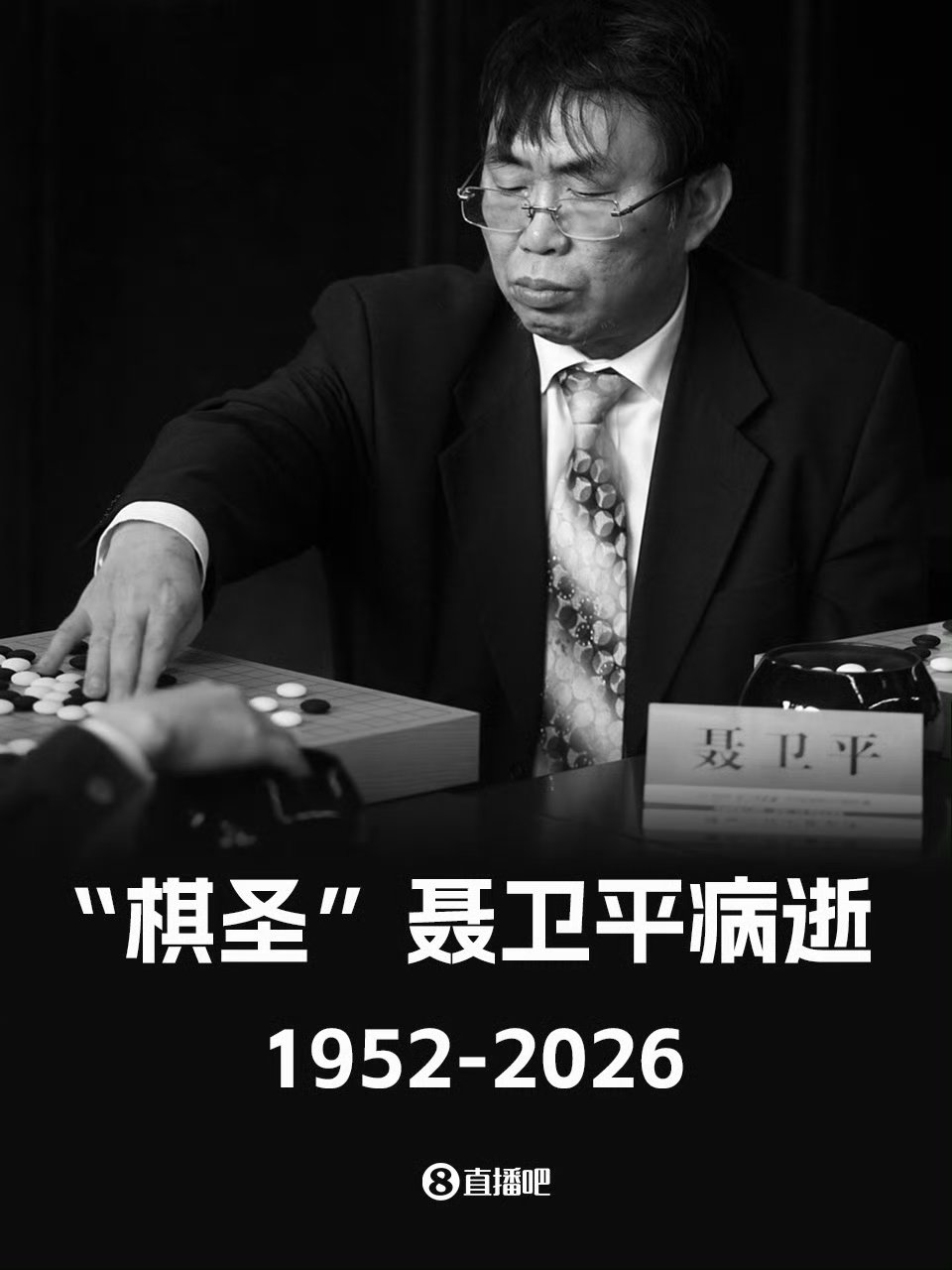

因为聂卫平九段的去世,这几天网上有各种他重大棋局的回顾,其中最多被提及的是首届围棋擂台赛的主将之战,聂卫平击败日方主帅藤泽秀行名誉棋圣,成为新中国围棋追赶日本的标志性胜利。

看到回顾文章中一张藤泽秀行的图片,回想起那局棋结束的傍晚,我放学较晚,是家里最后一个进门的,那时电视新闻上已经报道完,从省城休班回家的大姐跟我介绍:都在那里庆祝,就那个日本老头坐在那里东看看,西看看。

那时候,一家五口人,一个在满意的单位工作两年,一个上高中,一个上初中。在那个全国欢庆的日子里,充满希望的一家人在一起,幸福不过如此。

这几天调试完浪潮云会计,已经投入实战,就差选择哪种打印格式了。

可能是我在淘宝上搜索过的缘故,最近打开淘宝一直给我推财务软件,基本都是金蝶的,看着那图片上U盘模样的加密狗,再看看几乎都差不多的100块钱的mini版,不到200的标准版,我有点动心,心想大不了买一个测试一下。

但等点进去发现不对劲,因为卖家并不是金蝶,而是五花八门的挂着财务、软件的商铺。

于是转到京东的金蝶专营店,发现那坚挺的价格依旧。

当年就一堆偷偷摸摸卖加密狗的,现在直接在淘宝网上开卖了,时代真是进步了啊。

去年底在自己公众号《旧文旧局》系列回顾了聂卫平九段对依田纪基的对局,并在文末附录了作者程晓流极具个人情绪的评论,或者叫抒发。昨天有网友在那篇文章下面评论,可能认为我是对作者不满,写道,作者“跟聂老是莫逆之交,所以才敢说这样在别人看来很冒犯的话”。其实,二人关系我自然明了,我感慨的只是谁也没有想到这是聂卫平九段的擂台赛最后一局,那个他创造神话的擂台赛。没想到,今天一早就看到了聂卫平九段去世的消息。聂卫平九段有很多尊称,如聂老,聂棋圣等,但我心中最高的称呼依然是聂卫平九段。天堂的围棋殿中,再添一神。

去年底在自己公众号《旧文旧局》系列回顾了聂卫平九段对依田纪基的对局,并在文末附录了作者程晓流极具个人情绪的评论,或者叫抒发。昨天有网友在那篇文章下面评论,可能认为我是对作者不满,写道,作者“跟聂老是莫逆之交,所以才敢说这样在别人看来很冒犯的话”。其实,二人关系我自然明了,我感慨的只是谁也没有想到这是聂卫平九段的擂台赛最后一局,那个他创造神话的擂台赛。没想到,今天一早就看到了聂卫平九段去世的消息。聂卫平九段有很多尊称,如聂老,聂棋圣等,但我心中最高的称呼依然是聂卫平九段。天堂的围棋殿中,再添一神。

上午忙了大半天,中午跟外甥吃了顿大餐,让儿子自己解决的午饭,忙完往回赶的时候,有种亏欠了儿子的愧疚感,于是多做了一站路,在一个粤味点买了三个菜当晚餐。

店员在给我装盒时,旁边来了一个不到30岁的男子点了半只豉油鸡,然后从兜里掏出一把零钱,大部分是5元的,开始数钱。

现在这年头,除了超市的老头老太太,真是很少见到现金了。

当时不怕笑话的心态:不知道他是自己想改善生活,还是觉得跟爱的人一起吃更值得。

80年代曾看过一部东德电视剧,也就是80年代了,90年代就是德国了。名字叫《无情的战线》。其中一集是主角化妆进入入冲锋队头目们的聚会执行任务时,意外遭遇长刀之夜而重伤。

这个剧情既有突发性,又有历史参与感,实在是精巧又厚重。

党卫队血洗冲锋队,国内一直定义的是权力倾轧。后来看一部国外纪录片,一个德国学者接受采访时,提到长刀之夜被忽视的一点,就是在德国开了以正义之名无视生命权的头。这是纳粹罪行的始端。

美国那边,什么时候开始清洗ice了,那就是世界大乱的开始。

今天结合税务提交的财务报告,了解了一下类ERP财务软件关于财务费用存在的问题。

对写分录的而言,遵循的是“有借必有贷,借贷必相等”。而写代码的不懂也不管,他遵循的是科目已经设置了借贷方,那统计汇总的时候,就只统计对应科目的借方或者贷方。你利息费用既然归属于借方,你记到贷方的我不管,也不能管,管了就乱套了,程序计算量就太大了。

估计写代码的跟写分录的也讨论过,估计最后写代码的振振有词:你只是记住把数字用负数写到借方就行了,这多简单?我改代码?那得多大工作量,得加钱!

所以最后,也就那样了。所以从这一点就能推测出某个软件的核心源码,是不是出自开源的那些国外ERP。

还在研究odoo的时候,就看到网上有评论,说浪潮的云会计有跟odoo合作过。

初次接触浪潮云,感觉它跟odoo差别还是很大的。中国传统会计软件以凭证为中心,会计人员要熟练掌握一张凭证中的分录的借贷对应关系及录入;而odoo这类国外的ERP则更侧重账簿,即便一个业务人员不懂会计,只要按照权限在账簿中录入单向分录就可以。

不过今天在汇总年报功能的时候,发现浪潮云似乎还是“借鉴了”odoo,因为在银行利息入账时,他跟odoo等国外ERP一样,必须以负数记到借方,否则无法汇总到财务费用中。而老会计升级迭代的用友是不存在这个问题的。

说到底,还是写代码的应付写分录的。

在短视频平台上,给我推送的时政评论是主流,里面有的可看,大多数属于搬运加忽悠的。

不过好处也有,可以让自己脱开传统知识来源和灌输,换个角度思考。

这几天美国明尼苏达那边ice枪击案成了热点,网上自然是看热闹不嫌事大,但面带笑容评论总是让人看了不舒服。倒是一个中国话说的算是流利的美国人评论的好:将军们有了自己的队伍,这就是罗马帝国衰亡的重演。

国内更进一步,把ice比作冲锋队和盖世太保了。

但这没什么可庆祝了,美国乱了对中国未必是好事。毕竟中国有句老话:杀人放火金腰带。

昨天尝试了一下浪潮的云会计基础版,界面很简洁,基本的会计功能也都包括了,也算是物超所值了。

相比笨重繁冗的用友,基于云服务的基础版无疑更有竞争力,不是所有企业都需要大而全的软件,不过看着这基础版的功能和思路,跟我二十年前的构思大差不差,还是有些失落。

不过,这个基础版的开发者脑子还是灵活的,比如我一直头大的在线余额查询,他采用的方式很取巧,就是输入科目号后,余额直接显示在下面了,你输入完金额,那个余额也不会变化,只有点击保存后才会改变。

估计,这应该也是程序员应付会计员的招。